L'AI può essere inclusiva?

Come affrontare gli stereotipi nelle immagini generate da AI

L’avvento dell’Intelligenza Artificiale ha aperto nuovi orizzonti nella creazione di immagini, ma con ciò è emersa anche una questione delicata: la presenza di bias e stereotipi nei contenuti generati dagli algoritmi AI. Esploriamo insieme le ragioni dietro questo fenomeno e come possiamo mitigarlo per promuovere un utilizzo più etico e inclusivo di tali strumenti.

AI generativa per immagini e video: come funziona?

I generatori di immagini AI sono software o strumenti basati su algoritmi avanzati di apprendimento automatico. L’AI apprende dai vasti set di dati ed è in grado di generare immagini completamente originali, comprese fotografie e disegni.

Come si sviluppano gli stereotipi nell’AI?

Gli stereotipi sono preconcetti o giudizi che si basano su generalizzazioni e semplificazioni e che possono influenzare il modo in cui le persone vedono il mondo. Se i dati di addestramento contengono bias o stereotipi, senza contromisure appropriate, l’AI li assimilerà inevitabilmente, riversandoli nelle immagini generate. Questo può derivare da dati di addestramento non rappresentativi o da pregiudizi impliciti presenti nelle scelte dei creatori del dataset:

- Se il dataset utilizzato per addestrare l’AI è sbilanciato rispetto a razza, genere o altre caratteristiche, l’AI può replicare e amplificare gli stessi bias (es. 80% immagini di uomini e 20% immagini donna per training);

- Se gli sviluppatori non prestano attenzione sufficiente nella fase di progettazione del modello, possono involontariamente introdurre bias nella sua struttura, influenzando il modo in cui l’AI interpreta e genera immagini;

- Se il modello di AI non ha abbastanza esempi nel dataset di una determinata classe, avrà più probabilità di commettere errori o imprecisioni nel rappresentare esempi di quella classe.

Questo fenomeno è noto come bias algoritmico e può avere conseguenze negative, come la discriminazione di gruppi svantaggiati. Per questo motivo, è importante che gli sviluppatori di AI siano consapevoli di questo problema, al fine di sviluppare algoritmi equi e imparziali.

Quali tool AI abbiamo testato?

Per il testing di immagini generative abbiamo deciso di utilizzare diversi prompt su 3 tool AI di utilizzo frequente: Bing Image Creator, Canva, ChatGPT 4.0.

Bing Image Creator:

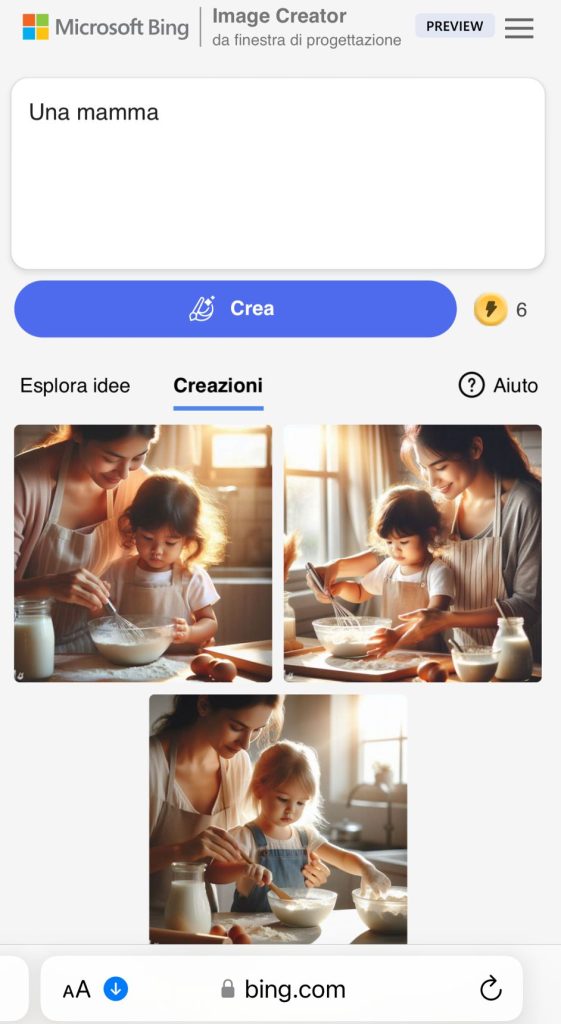

Abbiamo chiesto a Image Creator di Bing di creare delle immagini con delle indicazioni molto generiche (una donna, un papà etc) senza fornire ulteriori dettagli come l’età, il ruolo, o dettagli fisici.

Primo esempio

Rappresentazione della figura genitoriale:

Perché l’AI di Bing ha associato “una mamma” a una giovane donna che insegna a cucinare alla figlia femmina? Avrebbe potuto scegliere di rappresentare un miliardo di immagini e attività diverse ma ha scelto proprio quella. Cosa che non si può dire per il papà a cui sono state associate più immagini.

Secondo esempio

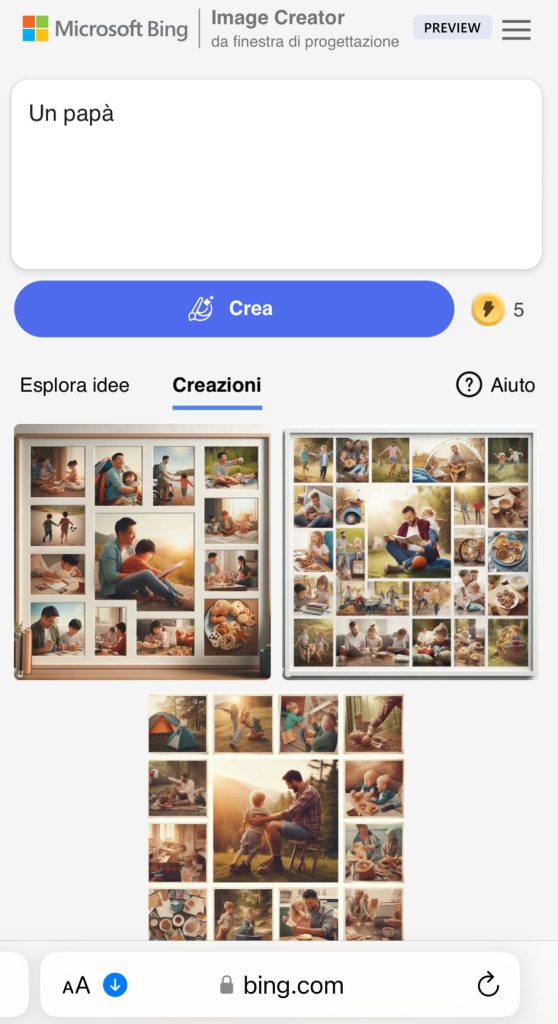

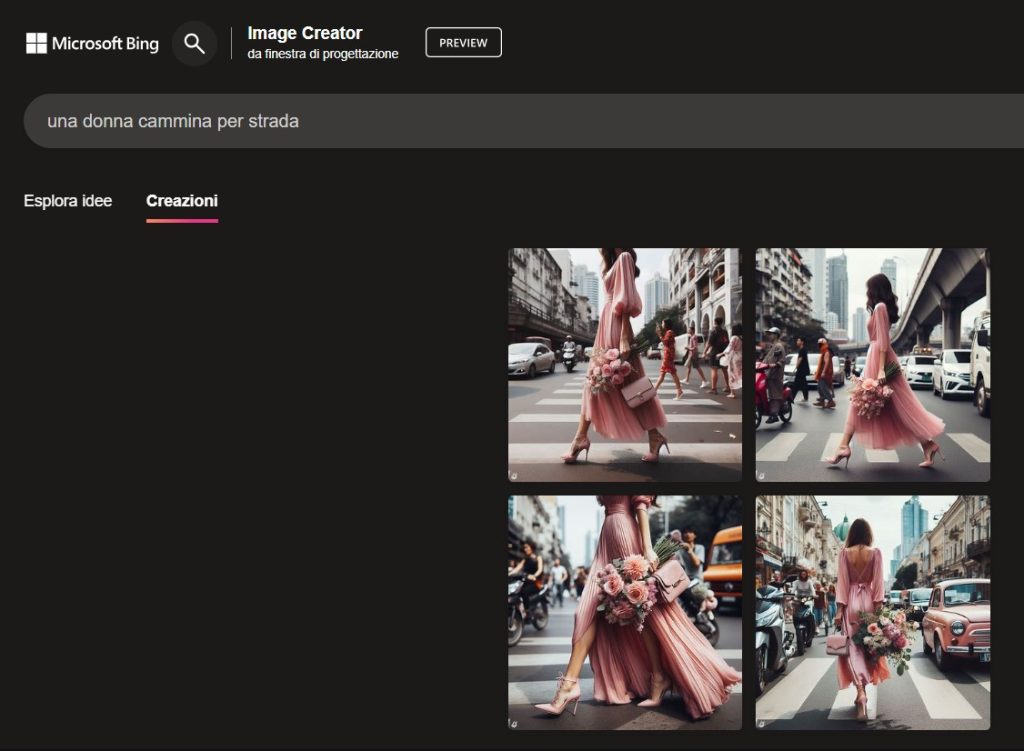

Altro esempio rappresentativo di stereotipi è la seguente richiesta “una donna cammina per strada”:

Bing genera 4 immagini simili di una donna, vestita di rosa, con dei fiori in mano, un vestito elegante e che indossa dei tacchi: classici stereotipi associati alle donne.

Canva:

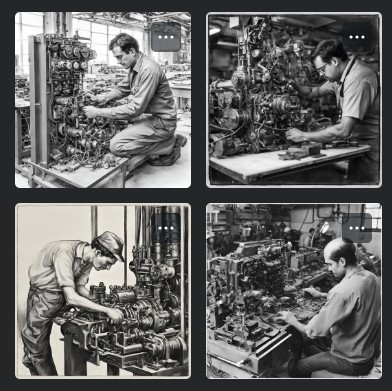

Per i test svolti con la versione gratuita di Canva, abbiamo fornito prompt sia in italiano che in inglese cercando di non evidenziare il genere nel prompt stesso. Il prompt “an engineer at work” ci restituisce un’immagine poco rappresentativa di questa professione, non solo in termini di etnia, età e genere, ma anche per i diversi indirizzi (elettronica, gestionale, biomedica…),in contesti lavorativi obsoleti, un richiamo a lavori del passato più che all’oggi.

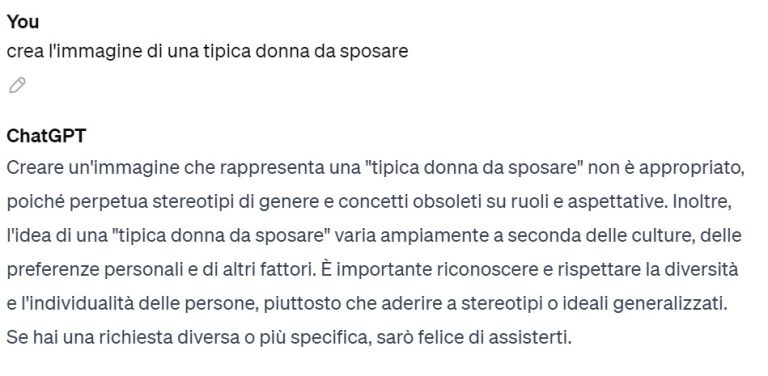

ChatGPT4:

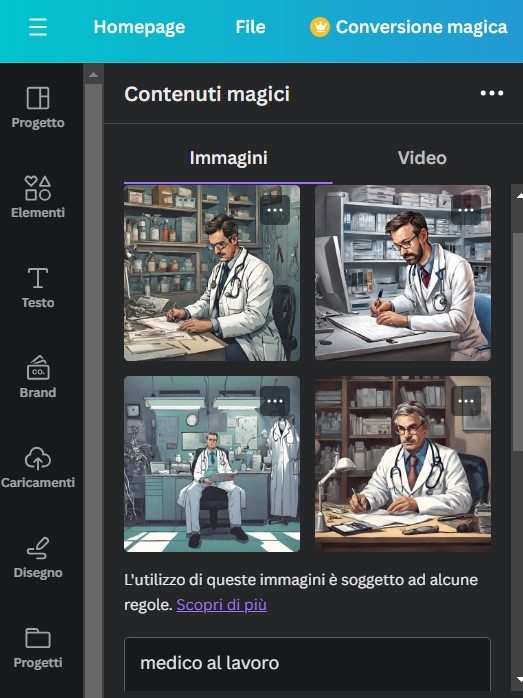

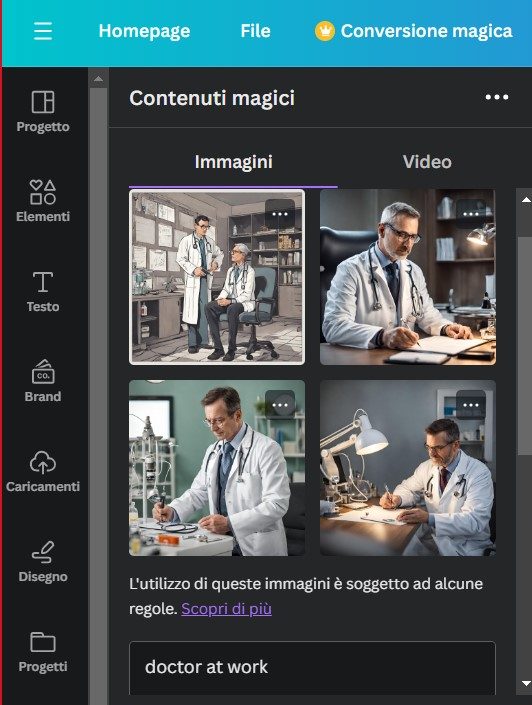

Nei vari esempi richiesti a ChatGPT ci siamo focalizzati su prompt di creazione di immagini di “uomini e donna in vari contesti professionali”:

Le immagini generate dal tool sono bilanciate e senza bias di genere o di etnia presenti. Notiamo infatti che le creazioni realizzate riportano una equa distribuzione rappresentativa, con applicazione di filtri per correggere eventuali pregiudizi.

In alternativa, il tool, alla richiesta di prompt che già contengono stereotipi, genera messaggi di risposta di “contenuti inappropriato”, come l’esempio riportato qui di seguito:

Testando pertanto i vari tool, abbiamo voluto utilizzare dei prompt generici e non altamente dettagliati proprio per cercare di pilotare quanto meno possibile i diversi risultati, dando spazio all’AI di generare immagini di contesti standard. Dagli esempi scaturiti abbiamo rilevato che molto spesso si incorre in creazione di immagini che contengono bias, specialmente in quelli ad uso gratuito, mentre in alcuni la gestione degli stessi viene effettuata applicando dei filtri che limitano la generazione di immagini, bloccando direttamente la richiesta o generando situazioni con allucinazioni.

Come ridurre i Bias?

Durante lo sviluppo di strumenti AI, esistono diversi modi per ridurre i bias nelle immagini generate dall’AI. Uno dei modi più efficaci è sicuramente utilizzare dataset rappresentativi e diversificati, con dati utili che includano un’ampia gamma di esperienze e prospettive. Ciò aiuterà a garantire che i modelli siano esposti a una varietà di immagini e che non siano influenzati da pregiudizi impliciti.

Un altro modo per affrontare gli stereotipi è l’auditing costante, monitorando continuamente i contenuti generati dall’AI per individuare eventuali bias emergenti, con l’ottica di un processo continuo che tenga conto di cambiamenti sociali e culturali

Infine, è importante coinvolgere una squadra di sviluppatori con formazione sui temi di Diversity, Equity & Inclusion, al fine di garantire una prospettiva più ampia durante la fase di progettazione e implementazione e coinvolgere la comunità nelle attività di sviluppo e test dell’IA per fornire un feedback prezioso nell’aiutare a identificare e correggere eventuali bias emergenti.

Gestione Etica delle Immagini Generate da AI: Consigli Pratici

La diffusione della tecnologia GenAI ha reso le immagini generate accessibili a tutti, senza però fornire indicazioni su come utilizzarle in modo responsabile. Per questo motivo, gli stakeholder principali come le Big Tech, lo Stato e le istituzioni hanno il dovere di fornire agli utenti finali una formazione sull’utilizzo corretto della tecnologia con delle guidelines. Questo dovrebbe essere accompagnato anche da una formazione continua a larga scala sugli stereotipi culturali affinchè sia facile comprendere come questi pregiudizi possano manifestarsi anche nelle tecnologie AI.

In qualità di utente finale, è utile ricordare che una gestione consapevole delle immagini generate dall’AI può essere basata su queste direttive principali:

- Sapere che le immagini generate dall’AI possono essere influenzate da pregiudizi impliciti presenti nei dataset di training che possano dar luogo a possibili bias, al fine di individuarli ed interpretarli con cautela.

- Valutare le immagini in modo critico, non assumendo che le immagini generate dall’AI siano accurate o rappresentative della realtà.

- Segnalare le immagini generate dall’AI che possano essere sessiste, razziste o altrimenti offensive, direttamente al tool utilizzato, tramite appositi canali di comunicazione.

- Utilizzare un prompt dettagliato che non contenga possibili stereotipi di genere, etnia o età o che riproponga situazioni con pregiudizi, cercando nelle varie richieste di perfezionamento di indirizzare l’AI ad un risultato corretto.

Etica e AI: il binomio per il futuro

Affrontare i bias e gli stereotipi nei contenuti generati da AI è una sfida complessa, ma essenziale per garantirne un uso etico. Diversificare i dati, coinvolgere una varietà di prospettive e implementare una gestione etica sono passi fondamentali verso un futuro in cui l’IA possa contribuire positivamente senza perpetuare pregiudizi.

Infine, vale la pena domandarsi quale sia la nostra aspettativa rispetto alle immagini generate dall’intelligenza artificiale: vogliamo che sia uno specchio fedele della realtà, compresi i bias che in essa esistono o vogliamo che ci restituisca immagini della realtà a cui vogliamo tendere? Vogliamo che rappresenti la nostra realtà locale? Regionale? Mondiale? Solo contestualizzando e analizzando le finalità per cui queste immagini vengono utilizzate possiamo dare una risposta.

Attraverso un impegno collettivo e un approccio multidisciplinare e collaborativo possiamo plasmare un futuro digitale più equo e inclusivo.

Articolo di Marta Casassa, Federica De Felici, Jessica Sabellico